By @Genaro Rebolledo Méndez

Generative Artificial Intelligence (GAI) and Deep Learning Language Models (DLM) are revolutionary technologies in the field of computer science and artificial intelligence. These technologies are making a significant impact on a variety of business models because of their ability to automatically generate text and images, perform accurate translations, assist users autonomously, and much more.

GAI consists of systems and algorithms capable of creating new and original content in the form of text, images, music, and other useful data for users and businesses. These systems learn patterns and characteristics from an original dataset to produce a data model that captures the essence of the training information. With this model, GAI can generate content that mimics the appearance and structure of the original dataset. One of the most prominent subfields of GAI is natural language processing (NLP), which focuses on generating and understanding human text.

Deep Learning Language Models are a category of GAI that specializes in text-based model generation. These algorithms have gained prominence in the past year as they have been trained on large amounts of linguistic data to learn the structure and relationships between words and phrases. One of the standout DLMs is the Generative Pre-trained Transformer (GPT) model, which uses a neural network architecture called Transformer to capture complex contexts and generate coherent and relevant text.

Two deep learning language models have captured the public's imagination: ChatGPT and Llama2, a text-generation model. Both models have demonstrated the potential to assist individuals, creators, and businesses by providing new ways to express themselves and connect with people. These models are used in various applications. In the customer service domain, DLMs can provide automatic and consistent responses to customer inquiries on websites and social media platforms. In education, they can generate study materials and detailed explanations of complex concepts. Furthermore, in the realm of creativity, they can compose poetry, write stories, and create music. In the translation industry, DLMs have significantly improved the accuracy and speed of automatic translation. They can understand context and language nuances, resulting in more natural and coherent translations. Additionally, DLMs are also being used in scientific research to analyze large text datasets and extract relevant information.

Despite their capabilities, DLMs are not without challenges. These systems could generate content that appears coherent but is false or misleading, raising ethical and trust issues. Moreover, interpreting and deeply understanding context is often a challenge, which can lead to inappropriate responses in certain situations. That's why the implementation of these systems requires expert human supervision to ensure they adhere to ethical guidelines and promote responsible AI practices. Additionally, the implementation of these systems must address potential biases, ensure transparency, and promote fairness in their application, as well as comply with existing legal contexts for personal data protection.

In summary, Generative Artificial Intelligence and Deep Learning Language Models are technological advancements that are transforming the way we interact with information. However, it is essential to monitor the performance of AI applications and continuously seek ways to optimize AI models and algorithms for better results in their specific usage context. Furthermore, it is necessary to identify potential risks associated with AI implementations and work on mitigating those risks while ensuring compliance with industry regulations and data privacy laws. As these technologies continue to evolve, addressing both their benefits and challenges is crucial to ensure ethical and effective use in various applications.

Escrito por @Leonardo Nhaux

AI sí... o AI no?

La IA ha generado una apasionante discusión sobre su impacto, y las opiniones van desde el milagro de un próspero futuro para el planeta y todos los que lo habitamos, hasta la catástrofe de la exterminación de la humanidad.

Esta edición de The Economist está principalmente dedicada al tema IA, y me parecieron muy interesantes los artículos, todos. Me animaría a decir que para los que estamos metidos en el tema, es un ejemplar de lectura obligada.

Abarcan temas tales como fundamentos de la IA, cómo funcionan los LLMs, que están haciendo los países para controlar su impacto, quienes proponen un uso más abierto de esta tecnología, quienes menos (con China a la cabeza), potenciales aplicaciones, el futuro del trabajo, y muy pero muy sutilmente, se menciona un tema que llamó mi atención de manera especial: la posibilidad de que la IA acabe con la humanidad.

En tres artículos se hace referencia a una encuesta realizada el año pasado a expertos de IA en diferentes países, a los que les hicieron la siguiente pregunta: “¿Cuál es su expectativa respecto al impacto que tendrá la IA sobre la humanidad?”

Las respuestas son las siguientes:

- Extremadamente buena: 10%

- Buena: 20%

- Neutral: 15%

- Mala: 10%

- Extremadamente mala: 5%

Y cito textual de uno de los artículos: “extremadamente mala, como por ejemplo la extinción de la humanidad”. Los diferentes autores intentan transmitir un mensaje positivo, haciendo una ponderación optimista e infiriendo que ese 5% de “extremadamente mala” es muy bajo. En lo personal, si estamos hablando de la aniquilación de los seres humanos, cualquier cifra arriba de cero se me hace altísima, y más aún teniendo en cuenta que la opinión proviene de personas que han dedicado sus vidas a estudiar el tema, y que cuentan con el prestigio suficiente como para que sean considerados para un estudio de esta magnitud.

Creo necesario aclarar, que lejos de ser partidario de las múltiples y extendidas teorías de complots y conspiraciones, soy un pensador positivo por naturaleza, y considero que cualquier invento, innovación, descubrimiento y/o creación, de cualquier cosa que tenga un impacto transformador a nivel global, debe aprovecharse para generar grandes beneficios para la humanidad. Indudablemente siempre habrá que considerar los riesgos y aspectos negativos, pero la evolución siempre cumplirá su propósito: “evolucionar”. Así mismo entiendo y estoy de acuerdo, en que deben existir instancias que controlen y regulen su desarrollo y utilización, y minimicen los riesgos de afectaciones contraproducentes a gran escala.

Volviendo al tema de la “catástrofe”, me parece muy difícil que alguien desde su casa, utilizando ChatGPT, vaya a destruir el mundo, pero también es cierto que la historia nos ha demostrado muchas veces, que un solo individuo, con el suficiente poder, motivación y recursos, puede causar “afectaciones contraproducentes a gran escala”.

El 1ro de septiembre de 1939, Alemania invade Polonia y da inicio a la 2da Guerra Mundial, la consecuencia: 50 millones de muertos.

El 6 y 9 de agosto de 1945, EEUU suelta sobre Japón dos bombas atómicas, y con esa trágica estrategia consigue poner fin a esa misma guerra, las consecuencias: más de 200,000 muertos, prácticamente todos ellos civiles, y décadas de padecimientos para los sobrevivientes.

Tanto Hitler como Truman tenían sus respectivas motivaciones para hacer lo que hicieron, estemos o no de acuerdo con ellas, pero principalmente, podían hacerlo, y tenían el poder y los medios.

Obviamente, los mortales de a pie no vamos a extinguir la humanidad experimentando con prompts, pero la nota refuerza la sospecha de que hay algo más debajo de la superficie, que solo unos pocos conocen, y que por el momento se está haciendo un esfuerzo para tratar de contener.

Leyendo estos artículos me vinieron a la mente tres noticias recientes, que sumadas podrían dar argumento a alguna serie de Netflix de varios capítulos.

- Un empleado de Google que dijo públicamente que la IA era peligrosa, fue despedido al siguiente día.

- En tecnología, hasta estos días al menos, cualquier resultado de un algoritmo, o de un programa de software, o sentencia de código fuente, o de un circuito electrónico, se puede predecir y replicar. Los propios creadores de los modelos de IA generativa, no pueden explicar algunos resultados producidos por las plataformas que ellos mismos diseñaron.

- Elon Musk y un grupo nutrido de gurús tecnológicos, firmaron e hicieron pública una carta solicitando se pause el desarrollo de IA por 6 meses.

Mientras tanto el avance de la IA sigue su vertiginosa avalancha de nuevos productos, aplicaciones, lanzamientos de novedosas soluciones, aparición de nuevas StartUps, inundando todos los aspectos de la vida de las personas, y cambiando las estructuras de los modelos económicos y comerciales tradicionales.

Es absolutamente evidente que la competencia entre los grandes grupos tecnológicos y económicos se mide por día, o tal vez por horas, y no van a escatimar esfuerzos para seguir creciendo sus capacidades en busca de tener una posición predominante en este ámbito.

A nosotros los mortales, no nos queda más que aprovechar estas innovaciones, para mejorar nuestra calidad de vida, la de nuestros allegados, ayudar a nuestros clientes a brindar mejores servicios que alcancen y beneficien a más personas, que los estándares de

educación se nivelen hacia arriba de manera que haya mejores condiciones de desarrollo para todos, que la calidad de los servicios de salud se potencie para salvar más vidas.

Imagino a un joven japonés, aquel 6 de agosto de 1945, despidiéndose de su familia al salir de su casa en Hiroshima, para ir a abrir su almacén. Nunca se enteró que a pocas cuadras de su local, se estrelló contra el piso un dispositivo muy avanzado, que implicó una inversión cuantiosa, en la que trabajaron algunos de los científicos más importantes de ese tiempo, y que al estrellarse arrasó en segundos con todo lo que había en un diámetro de 10km.

Quizás ese 5% de expertos en IA imagina algo parecido como consecuencia del desarrollo de este apasionante nuevo fenómeno.

Yo sigo optimista en que todo esto es para mejor, entusiasmado con todo lo que estoy estudiando y aprendiendo cada día, y esperando poder aportar mi experiencia y conocimientos para construir desde lo positivo.

Siguiendo a los medios que se especializan en el tema, rápidamente uno puede detectar los diferentes grupos con intereses comunes, cada uno alzando su voz para posicionar sus temas e intereses, y no perder espacio en esta carrera vertiginosa que recién está empezando.

Estoy seguro que la gran mayoría de quienes tuvimos la oportunidad de leer esta edición, experimentamos un flash back inmediato a la noticia del 29 de marzo, a la cual hice referencia anteriormente en esta nota, cuando ese grupo de expertos y empresarios del sector de TI, más de mil, incluidos Steve Wozniak y Elon Musk, publicaron esa carta abierta proponiendo detener el desarrollo de la IA por 6 meses, argumentando sin mucho detalle, que estos avances involucran riesgos mayores que se deben considerar.

Por supuesto nada pasó con esa solicitud, esos 6 meses ya pasaron y la vorágine por la liberación y consumo de aplicaciones de IA sigue creciendo exponencialmente, incluyendo el lanzamiento en julio, presentado por el propio Musk, de su nueva empresa de IA llamada xAI, y un reciente anuncio de Amazon, en relación a una inversión de 4 billones de dólares para subirse al ruedo (entró tarde al juego, le va costar más caro).

Seis meses en tecnología es un ciclo completo de innovación, y pensando fuera de la caja, esa carta abierta puede haber sido una estrategia para ganar tiempo y poder recuperar algo de terreno frente a los disrruptores, con OpenAI a la cabeza. (Elon Musk fue uno de los fundadores de OpenAI, pero salió en 2018 por desacuerdos en la gestión de la empresa)

O... quizás tenían información privilegiada, relacionada con “afectaciones contraproducentes a gran escala”.

Cualquiera haya sido la motivación, la realidad es que la IA se ha posicionado al tope de los temas de interés científico, político y económico, y no hay señales de que se vaya a detener.

Y esto nos obliga, a los que tenemos alguna responsabilidad sobre trabajadores, o estudiantes, o colaboradores, hasta con nuestros propios hijos y familiares, a sensibilizar la trascendencia de este fenómeno. En lo que el mundo se acaba, o no, las cosas definitivamente ya cambiaron, nuevas formas de comunicación, de aprendizaje, un nuevo cambio en los modelos de negocio, en la forma de trabajar.

Hasta finales del año pasado, todas las olas de transformación tenían a la tecnología como centro del cambio

Con la IA, inclusive el propio sector tecnológico está viviendo un rediseño estructural desde sus bases. El desarrollo de software, el diseño de hardware, las comunicaciones, y todos los demás componentes que conforman la columna vertebral del sector se están reinventando.

Y mientras tanto el debate entre el bien y el mal no se va a detener, la inercia del fenómeno tampoco. La mejor estrategia personal frente a la controversia es estudiar, aprender, mantenerse informado, actualizarse, y sumar desde una visión positiva.

Escrito por @Leonardo Nhaux

No hace ni un mes que Microsoft presentaba Bing Enterprise, un ChatGPT privado para empresas, esto mediante una muy presumida alianza con OpenAI.

Hace unos días, OpenAI anunció el lanzamiento de ChatGPT Enterprise que, si no son hermanos gemelos, al menos son primos gemelos.

En el propio anuncio de la compañía, que se puede consultar en su página web (https://openai.com/blog/introducing-chatgpt-enterprise), no hay información de costos, pero sí algunos datos de su valor: seguridad de la información, modelos de entrenamiento especializados para los usuarios, y acceso ilimitado a ChatGpt4, como los más destacados. Muy similar a los argumentos de Bing Enterprise.

No es sorpresa, más bien, yo quisiera pensar que así estuvo planeado y acordado entre ellos, primero Microsoft y un mes después OpenAI. Para que pudieran construir Bing Enterprise, la colaboración entre ambas compañías debió ser muy estrecha y alineada a sus objetivos estratégicos.

Esto marca otro salto cuántico de Microsoft para ponerse al frente de la carrera por el liderazgo tecnológico y de mercado, en el tema de Inteligencia Artificial.

Recordemos que para que exista IA tiene que haber información y datos y para obtener un máximo aprovechamiento de esta nueva tecnología, tener esos activos en la Nube es prácticamente indispensable.

La historia de las disrupciones se repite tal y como sucedió en el pasado con la industria del alojamiento (AirBnB), el transporte (Uber), servicios financieros (PayPal) y muchos otros más, donde los nuevos modelos de negocio no fueron aportados por los jugadores históricamente relevantes en esos sectores, si no por emprendedores que entendieron y tuvieron la capacidad de implementar velozmente, las nuevas reglas del juego de este nuevo mundo basado en Tecnología.

En esta oportunidad, los dueños del negocio de almacenamiento de datos (GCP/Azure/AWS) están siendo espectadores del boom transformador generado por una empresa que hoy reporta tener menos de 500 empleados, más de 200 millones de usuarios y un valor de mercado de 30 billones de dólares, y recién está empezando a monetizar hace unos pocos meses.

Pero hay de espectadores a espectadores y en este escenario es evidente que Microsoft entendió el juego mejor que sus competidores y está capitalizando esa visión.

En sus respectivos intentos por reaccionar, adicionalmente empezaron a aparecer algunas iniciativas donde destacan Bard (Google) y Llama 2 (Meta). AWS se tardó hasta abril para anunciar el desarrollo de su propio LLM, al que llamaron Titan. A la velocidad que lleva la adopción de esta nueva ola, pronto veremos si Amazon pudo hacer valer su ventaja de tener el 40% del mercado de Nube a nivel global.

En algún lugar leí un comentario de un alto funcionario de AWS, y aunque es una excelente excusa para no decir "nos tardamos en reaccionar", concuerdo con su mensaje: "Tan solo se han corrido un par de kilómetros de un maratón, imposible predecir quién será el ganador".

La tendencia ya no tiene discusión, la Inteligencia Artificial ya es una herramienta adoptada y utilizada diariamente para mejorar la productividad y la creatividad. El propio OpenAI presume en el lanzamiento de su modalidad Enterprise, que el 80% de las empresas del Fortune 500 ya utilizan su tecnología de manera consistente, y casi estoy seguro de que el otro 20% se subió en estos 8 días que transcurrieron desde que salió la noticia.

La presión sobre los CIOs se va a disparar, todos los CEOs van a querer tener su propio ChatGPT interno, para resolver con simples consultas en modo de diálogo, las dudas y necesidades de información indispensables para el ejercicio de su rol. Lo que antes consultaban a través de reportes que emanaban del Área de TI, a veces con días de atraso, hoy van a querer platicar con sus LLMs privados en tiempo real y sin intermediarios. Por nuestro lado, las empresas que proveemos los servicios tecnológicos que hacen posible esta transformación, tenemos la responsabilidad de prepararnos para la inevitable demanda que se avecina y una muy buena oportunidad de consolidar nuestra posición como socios estratégicos de nuestros respectivos clientes.

Oliver Rodriguez Linked In

Clear and effective communication is a fundamental element for the success of any project, regardless of its size, location, or complexity. Join us as we explore the importance of clear communication in project success and how it can be achieved, regardless of the project's scope or location. From local projects to globally distributed initiatives, the ability to communicate effectively among all stakeholders is essential in achieving project goals.

Projects often involve diverse teams, with members from different backgrounds, cultures, and even time zones. To overcome the challenges arising from these differences, the use of communication tools and platforms is crucial. Tools like Slack, Microsoft Teams, or Zoom provide real-time communication channels, enabling team members to exchange information, share updates, and address concerns promptly. By embracing these tools, project teams can break down communication barriers, foster effective collaboration, and ensure everyone is on the same page.

One of the primary challenges in project management is ensuring that all stakeholders have a shared understanding of project goals, requirements, and deliverables. Project management tools such as Asana, Jira, or Trello play a vital role in documenting and organizing project tasks, milestones, and timelines. These platforms provide a centralized space for stakeholders to collaborate, track progress, assign responsibilities, and provide feedback, promoting clear communication. Through shared documentation and regular updates, project teams can align their efforts and work towards common objectives, promoting clarity and reducing the risk of misunderstandings.

Collaboration is the lifeblood of any successful project. In addition to project management tools, collaborative platforms like Google Docs, Confluence, or SharePoint facilitate real-time collaboration on documents, presentations, and other project artifacts. By providing a shared workspace, these tools enable team members to work together, contribute ideas, and advance the project. Collaborative tools empower project teams to leverage the expertise of each team member, foster innovation, and enhance the overall quality of deliverables by promoting effective communication, idea sharing, and cross-functional collaboration.

Misunderstandings and ambiguities in project requirements can lead to costly delays and rework. Effective communication of requirements is crucial for project success. Tools such as online requirement management systems or collaborative documentation platforms offer structured and transparent ways to capture, refine, and communicate requirements. By leveraging these tools, project teams can ensure that all stakeholders have a clear understanding of the project's scope, objectives, and desired outcomes, reducing the risk of misalignment and misunderstandings.

Projects are inherently dynamic, and changes are likely to occur during their lifecycle. Clear communication becomes even more critical when it comes to managing changes effectively. Agile methodologies like Scrum or Kanban promote open and transparent communication through daily stand-up meetings, sprint planning sessions, and retrospectives. Communication tools like Slack or Microsoft Teams facilitate these agile ceremonies, enabling teams to adapt quickly, address challenges, and make informed decisions collaboratively.

To recap, clear communication is essential for project success. By adopting effective communication tools, establishing shared understanding, fostering collaboration, ensuring clarity in requirements, and adapting to change, project teams can overcome communication barriers and propel their projects towards success. Effective communication is the solid foundation upon which successful projects are built, regardless of their size or location.

Oliver Rodriguez Linked In

Software development projects are dynamic by nature, meaning that their scope and requirements change over time. This complexity creates significant challenges for companies that want to deliver successful software solutions. In this post, we will examine the difficulties of managing changing project requirements and discuss how adopting a flexible and agile approach can help organizations overcome these challenges.

The scope and requirements of a software development project often change as the client's needs become clearer or as new technical challenges emerge during the development process. A project may begin with a general idea of the desired product or system. However, as the project advances and more information are gathered, specific requirements may need to be adjusted or refined. This dynamism in the requirements can present significant challenges, requiring companies to adapt quickly and ensure the final product matches client expectations.

These changing requirements pose some challenges. The project team usually have to adjust to the new needs while keeping the project on track. The ability to integrate new requirements smoothly, manage resources effectively, and maintain open communication with the client is essential for the project's success.

To overcome the challenges of changing project requirements, organizations must adopt a flexible and agile approach to software development. This approach emphasizes collaboration, adaptability, and responsiveness to change. By dividing the project into smaller iterations, the team can focus on delivering tangible results in a shorter timeframe. This iterative approach allows for continuous improvement, early risk identification, and course correction when necessary.

By implementing an agile methodology, it allows for transforming the development plan in response to changing customer needs. Through regular interactions with the customer and feedback sessions, the team can effectively prioritize and integrate new features. The iterative development process ensures that changes are managed efficiently, and the final product meets customer expectations.

By adopting a flexible and agile approach, organizations gain several benefits. Firstly, it enables them to adapt more quickly to changes in requirements, ensuring that the project remains aligned with customer expectations. Secondly, it allows for better resource allocation, enabling teams to allocate resources based on changing priorities and project needs. Additionally, the iterative nature of agile development promotes early feedback, allowing for continuous improvement and risk mitigation.

Oliver Rodriguez Linked In

Often, large and complex business organizations require efficient agile management. If the company has multiple teams and projects in different locations, departments, or countries, a unified structure is needed to facilitate collaboration, improve visibility, and ensure consistent delivery of value throughout the organization.

Agile methodologies have revolutionized the software development world, but they don't always scale well to larger organizations. That's where the Scaled Agile Framework (SAFe®) comes in. It is a proven framework for implementing Agile at scale, and it has been embraced by many of the world's leading companies. In this blog post, we'll explore how this methodology can help you boost engagement, time-to-market, productivity, and quality.

Engagement: Putting the Focus on Collaboration

One of the key benefits of a large-scale agile methodology is that it fosters collaboration and engagement among teams. By breaking down barriers and encouraging cross-functional teams, a scaled agile approach creates an environment where everyone is working towards a common goal. The framework also provides a clear framework for communication and collaboration, which helps ensure that everyone is aligned and working towards the same objectives. This results in increased employee satisfaction and engagement, with studies showing that 10 to 50% of employees are happier and more engaged when working in this environment. By promoting collaboration and engagement, SAFe® helps create a more positive and productive work environment for everyone involved.

Time-to-Market: Streamlining the Release Cycle

Another benefit of SAFe® is that it helps streamline the release cycle, reducing time-to-market, providing a clear roadmap for product development, with regular check-ins and reviews to ensure that everything is on track. This allows teams to identify and address issues early on before they become major roadblocks. By improving transparency and communication, a lean enterprise framework helps teams work more efficiently, which ultimately leads to faster time-to-market. Studies have shown that implementing this program can lead to a 30 to 75% reduction in time-to-market, enabling organizations to quickly respond to changing market demands and stay ahead of the competition. With a faster release cycle, organizations can deliver products and features to customers more quickly, which can lead to increased customer satisfaction and loyalty. Overall, the system streamlined approach to product development can help organizations achieve better results, faster.

Productivity: Empowering Teams to Deliver More

Agile process also empowers teams to deliver more by providing a structured framework for continuous improvement. Studies have shown that implementing it can lead to an increase of 20 to 50% in productivity. A collaborative agile framework encourages teams to take ownership of their work and make decisions based on data and feedback. By providing regular opportunities for retrospectives and feedback, helping teams identify areas for improvement and implement changes quickly. This results in increased productivity, as teams are able to work more effectively and efficiently. The program focuses on continuous improvement ensures that teams are always looking for ways to optimize their processes and deliver better results. This not only benefits the organization, but also helps team members feel more empowered and engaged in their work. By promoting productivity and ownership, helping organizations build a culture of excellence and achieve their goals more efficiently.

Quality: Building Quality into the Development Process

Finally, SAFe® is designed to build quality into the development process from the very beginning. It provides a structured framework for testing and quality assurance, with regular check-ins and reviews to ensure that everything is on track. This helps teams catch issues early on before they become major problems. Studies have shown that using a methodology for agile portfolio management in enterprises can lead to a 25 to 75% improvement in quality. By emphasizing quality throughout the development process, the system helps ensure that the final product meets the highest standards. Putting focus on continuous testing and feedback helps teams identify and address issues before they impact the end user, reducing the risk of defects and improving customer satisfaction. With higher quality products, organizations can build a reputation for excellence and gain a competitive advantage in the marketplace. Ultimately, the framework emphasis on quality helps organizations deliver better products, faster, which benefits both the organization and its customers.

To wrap up, SAFe® is a powerful framework for implementing Agile at scale. By fostering collaboration and engagement, streamlining the release cycle, empowering teams to deliver more, and building quality into the development process, being able to help your organization achieve better results. If you're looking to scale Agile within your organization, it is worth considering.

Oliver Rodriguez Linked In

Today's business world is a fast-paced environment, where competition for talent has reached unprecedented levels of intensity. Attracting and retaining top-notch IT talent is increasingly challenging for companies, jeopardizing their capacity for growth and success. This is where Qualtop services can be of assistance. Nearshore outsourcing is an effective way to access skilled IT professionals, making it easy to obtain the quality services you need as fast as it can be done. Let's take a closer look at some of the benefits.

Unleash Your Company’s Potential with Outsourcing Amidst Fierce Talent Competition

The competition for IT talent is intense, and companies are struggling to keep up. The demand for skilled IT professionals is high, but the supply is limited. This is especially true in the United States and other developed countries where the cost of living is high, making it difficult to attract and retain top talent. This global delivery model can help alleviate this problem by providing access to a larger pool of highly skilled IT professionals.

Nearshore outsourcing allows companies to access a highly skilled workforce in countries with lower costs of living. This means that companies can attract and retain top talent without having to pay exorbitant salaries. Additionally, extended teams could provide a level of flexibility that is not possible with onshore teams. Companies can scale their teams up or down as needed to meet their changing needs.

Revolutionize Your IT Operations with Nearshore Service Providers

The demand for specialized IT services is growing immensely as the importance of technology in business increases. Experts in areas such as software development, cybersecurity, and data analysis are increasingly sought after by companies. To access these specialized services with advantages like quickness or cost saving, having a global talent network is extremely beneficial.

To expand the capabilities an enterprise needs, integrating specialized professionals through an extended development team could be helpful. Nearshore teams often have an abundance of individuals with a wide range of expertise, capable of adding value and quality in multiple areas. This translates to limitless access to talent without the need to create an internal team.

Expanding Your Business Without Limits

One of the biggest benefits of nearshore outsourcing is the lack of limitations. With this proximity outsourcing, companies are not limited to working with IT professionals in their local area. They can work with professionals from all over the world, which opens up a world of possibilities.

Global resource sharing allows companies to access IT professionals who may have a different perspective or approach to problem-solving. This can lead to innovative solutions that may not have been possible with an in-house team. Additionally, nearshore outsourcing allows companies to work with IT professionals who may have a better understanding of the local culture or market. To conclude, we can say that software development through nearshoring is a completely viable option for companies that are seeking to expand their workforce with highly skilled IT talent, while remaining flexible and leveraging the global talent pool. As competition for talent increases, nearshoring will become a more attractive choice for those companies interested in optimizing their technology budgets while maintaining the highest quality standards.

Escrito por @Leonardo Nhaux

Sobre el final de la primera década de este segundo milenio, el concepto “Cloud” estaba sólidamente posicionado como una de las principales tendencias. El poderoso argumento de transferir CapEx (Gasto de Capital) a OpEx (Gasto Operativo) funcionó, la promesa se cumplió, pero con enormes sorpresas.

No hace mucho tiempo atrás, la infraestructura tecnológica se presupuestaba, se compraba, se instalaba y el Área de Finanzas se olvidaba del tema hasta la próxima compra.

La “promesa” tenía algunos pilares destacados: alta disponibilidad, optimización de flujos de efectivo, velocidad de despliegue, seguridad y “reducción de costos”. El concepto se adoptó sin mayor resistencia y el consumo se disparó en los siguientes años.

En Qualtop somos un ”early adopter" de esta tecnología. En nuestro caso no solo fue visión, también influyó de manera importante una situación de fuerza mayor.

En julio del 2015, nuestras oficinas estaban en lo que fue el Centro del Software en Guadalajara (Jalisco) y en una de esas bíblicas lluvias torrenciales tapatías, una sección del techo colapsó, el agua se filtró, y de pronto una catarata de cientos de litros de agua se escurrió de manera ininterrumpida sobre nuestros servidores por más de dos horas, inundando nuestro site y ayudándonos a abrir el debate: ¿volvemos a construir nuestro site, o migramos a la Nube?

Pero como dice el dicho “No hay mal que por bien no venga”, migramos y eso nos ayudó a entender los enormes beneficios de este recurso, no solamente desde el punto de vista económico, sino como herramienta estratégica de competitividad que le da valor al negocio.

Los proveedores, clientes y el propio uso han ido madurando con el tiempo.

En el inicio solo era subir datos y respaldos, luego aplicaciones cada vez más complejas y así, la Nube se convirtió en uno de los pilares estructurales de cualquier proyecto de Transformación Digital.

Últimamente, la creciente adopción e implementación de proyectos y aplicaciones en Big Data, Machine Learning e Inteligencia Artificial, están potenciando un nuevo brinco exponencial en la utilización de plataformas y herramientas Cloud.

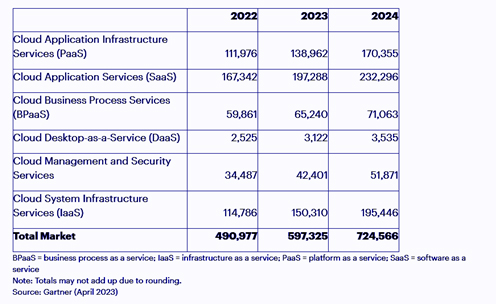

En un reciente comunicado de prensa, fechado al 19 de abril del presente año, Gartner pronostica un crecimiento del 20% en el consumo de Nube para este año, llegando casi a los 600 Billones de dólares y otro 20% adicional para el 2024.

En este nuevo formato de consumo a demanda, la infraestructura es un costo mensual, pero muchas veces genera sorpresas desagradables y de montos respetables.

Este traspaso de cuentas contables, de CapEx a OpEx, que a los financieros de las empresas les permite mayor fluidez en la Tesorería, mucha más flexibilidad en la ejecución de gastos y mayor control en la escalabilidad o desescalabilidad, dependiendo de los ciclos del negocio, tiene sus pros y contras.

Por un lado, los ciclos de aprobación de compra son muchos más rápidos, comparados con los procesos de adquisición de activos de alto valor económico. Pero, por otra parte, se requieren controles mucho más estrictos y justamente aquí empiezan las sorpresas, principalmente para las pequeñas y medianas empresas.

Las grandes corporaciones cuentan con los recursos y flujos necesarios para intentar hacer las cosas bien en términos de implementar proyectos estratégicos y realizar procesos de reingeniería complejos en sus negocios. Aunque no siempre tengan éxito, pueden contratar personal y servicios altamente capacitados, y con mucha experiencia, reciben foco de atención especial por parte de los grandes fabricantes de tecnología o prestadores de servicios globales, entre otras ventajas importantes que les brinda su propio tamaño.

En las PYMEs la historia es muy diferente. Necesitan actualizarse para mantenerse competitivas, pero con limitaciones importantes de recursos, tanto económicos como humanos, la creatividad se vuelve una necesidad y los riesgos una consecuencia latente e inevitable.

McKinsey realizó una interesante encuesta entre 200 CEOs e identificó 5 principales aprendizajes en proyectos de adopción de Nube:

- Esperar para ver resultados, puede salir muy caro. Migrar de On-Premise a la Nube por primera vez, es un viaje a lo desconocido para los dueños de las empresas o los CEOs, toman la decisión en base a proyecciones y justificaciones presentadas en Excel, y confían que los responsables del proyecto hagan bien su trabajo. Casi el 50% de los empresarios encuestados volvieron a revisar el estatus del proyecto de migración cuando los números brillaban a rojo fuego en sus Estados de Resultados. Tarde.

- Los Ejecutivos no se involucran en el proyecto. Migrar servidores y aplicaciones a la Nube, se percibe en la mayoría de los casos como un tema del Área de TI, y si el Director o Gerente correspondiente no tiene una visión global y financiera del negocio, el riesgo es que su medida de éxito se oriente hacia los aspectos técnicos, relegando las implicaciones económicas, hasta que estas mismas por su propio peso, terminan siendo el foco de atención de toda la compañía. Tarde.

- Se priorizan las actividades tácticas sobre las estratégicas. La encuesta reveló que el principal foco en relación con la gestión de los recursos de Nube, está puesto en la administración del contrato, la asignación de recursos y la estabilidad del servicio, descuidando considerablemente actividades de valor que pudieran potenciar los beneficios, como proveer proyecciones de consumo por área o por servicio, monitoreo preventivo de variaciones de carga de trabajo, implementar programas de gestión del cambio, o institucionalizar mejores prácticas de consumo de Nube en toda la organización. Finalmente, cuando se entiende la importancia, la Organización perdió dinero, y la posibilidad de capitalizar beneficios a tiempo. Tarde.

- Los responsables de administrar y controlar el consumo requieren de capacitación específica para la tarea. Por lo general estos roles se cubren con personal disponible del Área de TI y/o de Finanzas. En función de la relevancia que está tomando este recurso, controlar las implicaciones financieras requiere cada vez más de un nuevo nivel de especialización, inexistente hace una década atrás, pero de vital importancia en la actualidad.

- Las empresas tienen muy poco conocimiento de los aspectos económicos de cómo se cobra la utilización de la Nube. El uso de recursos en la nube como CPU, almacenamiento o transferencia de datos, genera ciertos costos, que se traducen en las denominadas Unidades de Nube y que corresponden directamente al tipo de uso de la infraestructura informática. El desconocimiento de estos conceptos por parte de las diferentes Áreas del Negocio produce decisiones desinformadas con sus correspondientes consecuencias negativas.

Con dificultades y desafíos, la inclinación es indiscutible: todo tiende a la Nube. Y con el tamaño de gasto que esto representa, cualquier ineficiencia en su utilización representa cantidades importantes de dinero.

IDC estima que el gasto de nube desperdiciado varía entre el 10% y el 30% del consumo total global. Basándonos en las proyecciones de Gartner, esto representa en dinero, entre 60 y 180 billones de dólares, literalmente regalados a los proveedores de Nube, sin ningún beneficio concreto para las empresas usuarias.

El problema tiene una dimensión suficientemente atractiva como para motivar acciones correctivas y así nace The FinOps Foundation en Febrero del 2019. (https://www.finops.org/)

FinOps es un modelo de referencia que se enfoca en el costo y la eficiencia del uso de la Nube. En esencia, es un cambio de cultura que busca institucionalizar la responsabilidad financiera en la utilización de estos recursos, en todas las áreas del Negocio.

La propia definición de “The FinOps Foundation” es la siguiente: una disciplina en evolución, de gestión financiera de la Nube, y una práctica cultural que permite a las organizaciones obtener el máximo valor comercial al ayudar a los equipos de ingeniería, finanzas, tecnología y negocios, a colaborar en las decisiones de gasto basadas en datos.

¿Cuál es el valor de implementar FinOps en una Organización?

Como cualquier modelo de mejora continua, los resultados se van haciendo más visibles en la medida que la Organización va madurando en el proceso de institucionalización de las mejores prácticas. Finalmente, el esfuerzo se transforma en los siguientes beneficios:

- Identificación oportuna de patrones de gasto.

- Identificación de áreas ineficientes en el uso de los recursos.

- Mayor transparencia en la utilización de la Nube.

- Eficiencia en el monitoreo y control de los consumos.

- Optimización del desempeño de los servicios y/o productos alojados en la Nube.

- Provisiones de gasto y proyecciones de consumo más predecibles.

- Mayor valor del Negocio en general.

A medida que las nuevas tendencias tecnológicas van cobrando consistencia y expandiendo su popularidad, el gasto en Nube va a seguir creciendo y ocupando un lugar destacado en las estructuras de costo de las empresas.

A los profesionistas responsables de administrar estos recursos, les toca entender el impacto financiero de las decisiones que toman al respecto, otorgándole un nivel de importancia similar al del éxito técnico y tecnológico.

A los proveedores e integradores de servicios, nos toca ayudar a nuestros clientes a acelerar los procesos de adopción de estas mejores prácticas. En particular, en Qualtop, nos tomamos el tema con mucha responsabilidad y hemos estado realizando importantes inversiones en capacitar a nuestros expertos, lograr altos niveles de especialización y fomentar internamente las mismas prácticas que promovemos.

A los proveedores de Nube, les toca… seguir facturando.

Para terminar, y en agradecimiento a los que tuvieron la gentileza de leer este artículo, les comparto una interesante guía de herramientas, clasificadas por Nube, para la mejor administración de este valioso recurso. Cortesía de “The FinOps Foundation”.

Escrito por @Leonardo Nhaux

En la Encuesta a Developers 2023 de Stack Overflow, me atrajo un tema en particular: ¿Qué tanto utilizan AI los desarrolladores de software en su día a día?

El reporte está muy completo, y en base a una muestra de 90,000 encuestados de varios países, aborda una amplia gama de aspectos claves de esta industria en relación con su principal actor: El Desarrollador de Software.

Destaca claras preferencias tales como: el 80% de los encuestados prefiere capacitarse on-line, Java es el lenguaje de programación más utilizado por onceavo año consecutivo, Confluence y Jira nuevamente liderando en "Herramientas de colaboración". En el rubro de "Tecnologías más admiradas": Rust es el lenguaje ganador con más del 80% de las preferencias, Matlab el menos, y Phenix es el framework elegido.

En cuanto a los esquemas de trabajo, no es ninguna sorpresa que las preferencias se inclinan hacia la modalidad de trabajo híbrido y/o home office. Más del 50% de los empleados en organizaciones de más de 5,000 empleados, operan en este formato.

Hasta aquí hice un breve resumen de aquellos datos que me llamaron la atención en lo personal, pero al final de la nota les dejo la liga para quién le interese revisar otros temas de la Encuesta. La verdad, vale mucho la pena.

Y ya entrando en materia, en cuanto a herramientas de AI lógicamente ChatGPT lidera el cuadro con 83.24%, pero entendamos que esta carrera empezó recién hace poco más de 6 meses, es muy prematuro decretar tendencia, pero no cabe duda de que OpenAI puso el pié primero, y de manera contundente.

En un apartado del documento, que se llama "Sentimiento de los developers en relación con la Inteligencia Artificial", Stack Overflow nos compartió los detalles cuantitativos de la encuesta, y justamente ahí está el dato que captó mi atención diferenciada: Los desarrolladores con menos años de experiencia, son los que más uso hacen de las herramientas de AI.

En general, el 77% de los encuestados indicaron opinaron que están "a favor" o "muy a favor" de la utilización de herramientas de AI en sus proyectos de desarrollo de software, resaltando que "Productividad" es el principal beneficio, pero cuando abren el dato y lo clasifican por años de experiencia, se ve claramente este fenómeno.

Y no dudo que pueda haber algún developer que a los 35 años decidió cambiar de carrera y recién tiene 1 año de experiencia en esta industria, pero en su gran mayoría, ese segmento se refiere a jóvenes de entre 20 y 23 años de edad.

Estos chicos y chicas son nativos digitales, su lógica de resolución de dudas o problemas es simple: tecnología primero, pensar después. Su cerebro ya está cableado en alineación fluida con los conceptos básicos de la AI, mientras que nosotros cargamos con estructuras mentales rígidas, talladas en nuestro Cortex, modeladas por décadas de procesos mentales basados en razonamiento y lógica.

Todo este fenómeno explotó apenas el 30 de noviembre del año pasado, cuando OpenAI abrió la caja de pandora y soltó ChatGPT.

La situación para los Desarrolladores "Senior" es complicada, porque necesariamente hay que desaprender, romper las estructuras mentales que condicionan el pensamiento, para dar cabida a una completamente nueva forma de trabajar.

Un Zelenial no tiene este obstáculo, no tiene que desaprender, se ahorra todo ese importante lapso de tiempo. Ellos ya están aprendiendo, desde cero y con la mente en limpio, sólo tienen que aprender a hacerlo como de la nueva manera, y es lo que hoy están haciendo mientras nosotros desaprendemos.

Es muy probable que dentro de tres años, los reclutadores tengan que tomar un decisión que nunca antes se les había presentado: contratar un desarrollador con tres años de experiencia de 23 años de edad, o uno con tres años de experiencia, pero con 40 años de edad.

Los de la Generación X sabemos la respuesta.

Muchas gracias a Stack Overflow por este increíble reporte.

Aquí les comparto los links:

2023 Developer Survey: https://survey.stackoverflow.co/2023/

Developer sentiment around AI/ML: https://stackoverflow.co/labs/developer-sentiment-ai-ml/